- Speaker #0

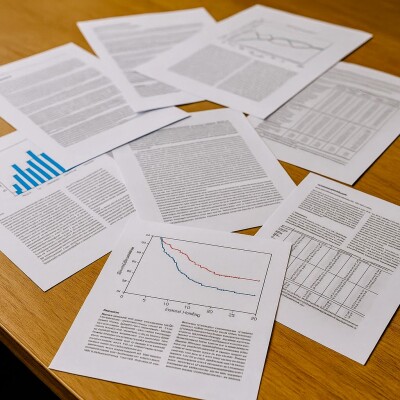

Bonjour à tous et bienvenue sur Superdocteur ! Aujourd'hui, je suis très heureux d'accueillir à nouveau Bastien Jeunet, chef de clinique en santé publique, doctorant en épidémiologie clinique et docteur en gériatrie. Bastien m'a proposé un sujet qui a suscité un énorme intérêt chez moi, à savoir l'intégrité scientifique. En effet, cela fait un bon moment que l'honnêteté et la rigueur scientifique semblent devenir de véritables sujets dans le monde universitaire. Alors que je trouvais ça passionnant de poser... toutes mes questions à Bastien sur ce phénomène pour essayer de saisir ses contours. Bonjour Bastien !

- Speaker #1

Salut !

- Speaker #0

Bastien, pourquoi faire un tel épisode sur l'intégrité scientifique ?

- Speaker #1

Très très bonne question qu'il faudrait que tout le monde se pose. Ce qu'il faut quand même se dire, c'est que de plus en plus, avec ce qu'on a eu notamment au niveau du Covid, le fait d'être intègre dans sa recherche est quand même de plus en plus important. On a pu le constater dans de nombreuses recherches qui ont été faites dans ce contexte-là et publiées. et puis finalement retiré après analyse plus approfondie. Il y a aussi autre chose qui peut expliquer cette importance, c'est qu'on remarque de plus en plus que la population qui n'est pas scientifique, entre guillemets, générale, a quand même une défiance de plus en plus importante envers le monde scientifique. Et ça, c'est quelque chose de bien rapporté, notamment par Étienne Klein, qui en parle beaucoup dans son livre Le goût du vrai. Et puis, il y a aussi de plus en plus d'étudiants, de plus en plus de chercheurs, avec en plus un système de valorisation de la recherche qui est plus ou moins discutable.

- Speaker #0

Est-ce que tu as l'impression que c'est quelque chose de nouveau ou ça a toujours existé ?

- Speaker #1

Je pense que malheureusement, c'est intrinsèque à la recherche, mais que ça s'empire de plus en plus par le système de recherche qu'on a et la valorisation des publications.

- Speaker #0

Est-ce que tu peux nous expliquer comment fonctionne la recherche médicale en France et ses publications ?

- Speaker #1

Alors, comment ça marche ? Globalement, quand on veut soumettre un article qu'on a fait de recherche, on soumet ça à un journal scientifique. la recherche en France, elle marche à soumettre des articles à un journal. Et l'idée, c'est que quand on soumet un article à un journal, après, on valorise sa recherche, et donc on est jugé en tant, entre guillemets, que bon chercheur selon différents index qui permettent de classer les recherches qu'on a faites et le journal dans lequel on a publié. Et donc, en France, le problème, c'est que pour être chercheur, il faut publier. Et donc, c'est souvent un truc que décrivent très bien les Anglais, puisque ce n'est pas qu'en France que ça marche comme ça, qui s'appelle le publisher perish. C'est-à-dire qu'il y a une pression à la publication, au nombre de publications en plus, et pas forcément à la qualité. Et donc, on retrouve des chercheurs qui sont jugés comme des bons chercheurs parce qu'ils publient beaucoup, pas forcément qu'ils publient en qualité. Et pour un peu prendre un exemple et illustrer ça, par exemple, on peut voir qu'il y a différents indicateurs en France qui sont utilisés pour juger de la qualité d'un chercheur ou d'un journal. Par exemple, l'impact factor qui est là fait pour juger la qualité d'un journal qui reflète le nombre moyen de citations qu'il a fait par article publié par ce même journal sur deux ans donc vous voyez c'est quelque chose qui juge une quantité de citations et pas une qualité et puis il y a d'autres index comme par exemple l'âge factor qui là sert à qualifier la qualité d'auteur où c'est égal au nombre N de publications qui ont été citées au moins N fois d'accord encore une fois on ne juge pas la qualité on juge une quantité Merci. Et puis, il y a un autre système qui, lui, pour le coup, est très franco-français, qui s'appelle le système SIGAPS, qui est un système aussi fortement critiquable, puisqu'il était fait initialement pour décider comment on répartissait l'argent entre les services par rapport à leur activité de recherche et les hôpitaux en France, et pas du tout pour estimer la qualité des chercheurs. Et en fait, ça a été utilisé pour estimer la qualité des chercheurs, et en gros, ça résulte tout simplement d'un produit entre la place de l'auteur dans l'article, donc vous voyez tout de suite les conflits qui peuvent... se faire entre les auteurs quand on fait un article, et l'impact factor de la revue, qui est déjà biaisé lui-même. Donc vous voyez, c'est des choses qui incitent, encore une fois, à la quantité et pas à la qualité.

- Speaker #0

Tu peux nous détailler ce que c'est le système SIGAPS ?

- Speaker #1

Le SIGAPS, il a un intérêt par rapport à l'affiliation qu'a un auteur, par rapport à un service de recherche, et pas par rapport à l'auteur. Vous voyez, par exemple, quand il y a un article, il y a un petit 1, un petit 2 avec écrit « Travail ici » , Ça, c'est mis parce que ça rapporte de l'argent. à l'hôpital qui est cité. Maintenant, c'est même un critère dans certaines facs pour être PU-PH ou être MCU-PH.

- Speaker #0

Est-ce que tu peux m'expliquer comment on pratique, on peut tricher dans la recherche ?

- Speaker #1

Alors, comment on peut tricher ? Il y a différentes façons de tricher. La première, on va dire, qui est assez simple, c'est tout simplement le fait de jouer dans ce rôle de quantité de publication. Là, on ne parle pas de la publication, on parle juste du fait de publier. d'une certaine manière ou beaucoup. Et donc, il y a par exemple des auteurs qui s'amusent à s'auto-citer, ce qui est totalement interdit. Par exemple, il y a des auteurs qui citent 5 de leurs articles dans un article qu'ils publient, alors que ça n'a aucun rapport avec le sujet. Donc ça, ça arrive assez fréquemment. Quand vous allez voir dans les références, parfois vous en voyez qui abusent un peu de ça. Je ne citerai pas des noms, mais il y en a qui se sont fait épingler pour ça récemment. Il y a aussi le fait de découper des travaux de recherche qu'on a fait en plusieurs publications, alors que pourtant ils répondent à la même question, mais en fait ça fait deux articles, donc deux publications différentes, donc plus de points. Ça s'appelle la salami publication ou le slicing, c'est la même chose. Et puis, il y a aussi parfois des conflits entre les auteurs, avec des places d'authorship et des gens qui sont mis sur une publication alors qu'ils n'ont rien fait, ou qui n'ont pas été mis alors qu'ils ont tout fait, ou qui sont mis pour assurer une publication. Et tout ça, de toute façon, c'est régulé au niveau de la loi. Et il y a des références qui ont été faites, notamment par les comités de revue et la HAS. Donc une fois qu'il y a ces triches-là... et qu'on a parlé de ces triches-là, il y a les triches qui se font sur un papier en soi ou sur un travail de recherche. Et là, globalement, ça se divise en deux. Il y en a un qui est très grave, mais peu fréquent, et l'autre qui est plus fréquent, mais moins grave. Le peu fréquent, mais très grave, c'est ce qu'on appelle la fraude. Et la fraude, ça représente environ 30% des articles qui sont rétractés, c'est-à-dire qui ont été publiés, finalement qui sont enlevés du journal parce qu'on estime qu'ils sont plus valables. Sachant que les articles rétractés, c'est moins d'un pour cent des articles de littérature. Donc, il faut rester positif et ne pas se dire que le monde est malveillant. Et donc, l'idée, c'est que ça, c'est la plus grave erreur. Parce qu'en fait, c'est des choses qui sont très grossières, entre guillemets. Donc, c'est par exemple le fait du plagiat, chose qui est très décrite. C'est le fait de citer quelque chose et de reproduire illégalement quelque chose sans citer la source, sans avoir l'autorisation de le faire. Ça peut se faire dans l'art, ça peut se faire sur les tableaux, ça peut se faire dans la musique, ce n'est pas quelque chose que de scientifique. Et puis après, il y a d'autres choses qui sont beaucoup plus graves et qui ont notamment été faites par un autre scientifique qui a travaillé beaucoup sur la sclérose en plaques et l'association avec les vaccinations contre la rougeole, je ne citerai pas le nom non plus, qui est carrément de la fabrication, de la falsification de données. Donc là, c'est carrément, je fabrique des données qui n'existent pas dans mon tableau ou j'en invente ou je les supprime. Et donc ça, vous imaginez tout de suite, pas besoin de faire un dessin, c'est le pire. Voilà, donc ça, c'est le pire du pire. Et puis après, il y a le moins pire, mais qui est le plus fréquent. Et c'est sur celui-là qu'on essaie de plus en plus de jouer, parce que le premier, on va dire que ça commence à être réglé, ce problème-là, c'est ce qu'on appelle la zone grise. Et donc là, c'est 70% des articles rétractés. Et pour illustrer un peu ça, un chercheur qui a dit ça, qui s'appelle Benjamin Disraeli, il avait dit qu'il existe trois types de mensonges en recherche. Il y a les mensonges, les gros mensonges. et les statistiques. C'est pour vous distraire un peu ça, c'est que les statistiques et les articles, on peut leur faire un peu dire ce qu'on veut. Et ça, c'est de la zone grise, parce que ce n'est finalement pas de la triche, c'est de l'omission, de la mise en forme, c'est des choses comme ça. Ce que dit par exemple la Cochrane qui a étudié cette zone grise, elle dit que lors d'une étude qu'elle a faite, 43% des essais cliniques sont concernés par ce genre d'erreur. C'est énorme sur une revue systématique. Et donc, je vais vous donner des exemples à titre non exhaustif, évidemment. Mais par exemple, ce qu'on peut faire pour tricher, c'est ce qu'on appelle le cherry picking. C'est-à-dire que lors de la conception et de l'analyse de l'étude, on avait dit au départ qu'on prenait un critère de jugement initial. Et puis finalement, les résultats ne sont pas bons sur ce critère de jugement. Donc finalement, dans ce qu'on met finalement dans notre rapport, c'est un autre critère qui apparaît. Un critère de jugement secondaire, une analyse en sous-groupe, voilà. Et puis on dit, voilà, ça, regardez, notre résultat, il est bon, quoi. Il y a aussi un truc un peu plus fin qui s'appelle le spin, où là, pour le coup, ce n'est pas on prend un mauvais marqueur, c'est on rédige d'une certaine manière. En gros, au niveau méthodologique, on n'est pas si mal, mais dans la partie rédaction des résultats, on raconte un peu un truc différent. On dit, oui, en fait, finalement, ce résultat-là, il n'est pas significatif, mais regardez, on a fait des analyses, et finalement, les autres analyses, elles sont intéressantes quand même. C'est dans la rédaction de l'article que ça joue, et ça s'appelle un spin, c'est le fait de changer quelque chose en trichant dans ce qu'on raconte. lisez les tableaux, ne lisez pas la partie résultats, parce que c'est notamment pour ça. Et puis, il y a aussi ce qu'on appelle le selective reporting, où là, c'est l'idée qu'on va sélectionner des choses et on va omettre. Et donc, le selective reporting, ça peut être sur tout un article. Donc, c'est ce qu'on appelle le biais de publication, par exemple. On a des résultats négatifs, donc on ne le publie pas. Ça peut aussi considérer une population. On a fait une étude dans une certaine population, on voit que ça ne sort pas. Bon, tiens, finalement, on va peut-être exclure ces patients-là. et puis avec cette population-là, ça marche mieux. Ou on va, par exemple, carrément... omettre des critères de jugement qu'on avait dit initialement.

- Speaker #0

Et puis, il y a aussi la question des conflits d'intérêts.

- Speaker #1

Et oui, la fameuse question des conflits d'intérêts. J'allais oublier, mais c'est quand même un petit peu important. Alors, le conflit d'intérêts, déjà, qu'est-ce que c'est ? C'est l'idée que selon la loi de transparence d'octobre 2013 en France, donc c'est quand même dans la loi, c'est une situation où il y a une interférence entre un intérêt public et d'autres intérêts publics ou privés. Donc vous voyez, il peut y avoir des interférences, pas forcément qu'avec des industriels, mais aussi avec des institutions. Tout de suite, ça change un peu l'idée en disant qu'il n'y a pas que les mauvais industriels, méchants pharmaceutiques qui peuvent influencer. Il y a aussi très bien un directeur de labo qui peut influencer, qui peut être un conflit d'intérêts. Et donc c'est cette situation d'interférence qui du coup va entraîner le fait qu'il va y avoir une influence qui va faire qu'on n'a pas un exercice indépendant en termes de chercheurs. Et on estime, en France, En s'étant inspiré de ce qu'on appelle le Sunshine Act aux États-Unis, qu'un conflit d'intérêt, c'est au-delà de 10 euros. Je ne sais pas d'où ça vient, je ne sais pas pourquoi, mais tous les conflits d'intérêt qui apparaissent sur transparence.gov, que vous pouvez aller voir, vous trouvez tous les médecins dessus, si vous voulez voir leurs conflits, ils sont obligés de les déclarer. Il n'y a que ceux qui sont au-dessus de 10 euros qui apparaissent. Déjà, quand il n'y a pas d'argent, ce n'est pas dedans. Dans des congrès, des chercheurs qui se présentent en disant pour moi c'est très simple avec tout le monde du coup j'ai pas de conflit d'intérêt Sauf qu'en fait, ça ne marche pas. Ce n'est pas à la personne qui présente de juger de son conflit d'intérêt. Elle présente objectivement tous les conflits qu'elle a, tous les liens qu'elle a, et c'est au public de décider s'il y a un lien ou pas.

- Speaker #0

Est-ce qu'on triche en France ?

- Speaker #1

Je pense qu'on triche partout. Je pense que la majorité des articles publiés et de la recherche qui est faite n'est pas de la triche, parce qu'il faut quand même être optimiste. et qu'en plus, en France, on a un prêtre. très gros moteur depuis quelques années dans toutes les facs et dans tous les chercheurs, en particulier les TESAR, de faire attention à ça. Le Covid, ça a vraiment mis au jour des grandes situations de conflits et de liens d'intérêt. Et je suis assez confiant parce que globalement, les chercheurs sont de plus en plus formés à ça. Une organisation qui se fait autour de ça, des référents dans chaque fac, etc. Donc il y a des solutions et des envies de mieux faire.

- Speaker #0

Alors, au vu de tout ce que tu nous as décrit concernant les triches, les erreurs méthodologiques, les fraudes, les conflits d'intérêts, est-ce que tu peux nous dire comment est-ce qu'on peut contrôler l'intégrité des chercheurs ?

- Speaker #1

Eh bien, on peut la faire de plusieurs manières. Elle se fait un peu en fonction des endroits où le chercheur a une responsabilité. C'est-à-dire que le chercheur a une responsabilité du début jusqu'à la fin du travail de recherche, qui est de la collection de données et du plan d'analyse initial à la publication des résultats. et en fait sur chaque étape on peut essayer de verrouiller les choses, par exemple par des pairs, comme on fait quand on fait des tests de sciences, mais aussi par d'autres solutions. Alors, l'idéal c'est de former tous les chercheurs à l'intégrité scientifique, ce qui est obligatoire maintenant. Nous, en tests de sciences, par exemple à Sorbonne, on est obligé d'avoir une formation d'intégrité scientifique pour être taisé. Une des solutions aussi, quand on rédige son protocole, c'est de s'approcher de méthodologistes ou de gens qui sont des vrais méthodologistes de métier et qui vont permettre d'aider sur la... conception de l'étude. C'est aussi une fois qu'on a fait son protocole, de le publier. Donc, il y a Clinical Trial qui existe pour les essais interventionnels, mais il y a aussi de plus en plus de journaux scientifiques, comme le BMJ, le BMC, qui publient des articles qui sont des protocoles. Donc, ça se fait de plus en plus parce que, quand on a publié son protocole, on est obligé de le citer, finalement, dans la publie qu'on va faire une fois qu'on a fini son étude. Et bien, c'est simple. S'il y a dissociation entre ce qu'on avait dit qu'on allait et ce qu'on a fait, là, on ne peut rien cacher. Et puis, il y a échanger avec d'autres chercheurs, c'est très important aussi. Après, il y a aussi une autre piste qui est intéressante, c'est comment on note les chercheurs. Ça, c'est autre chose, parce qu'il faut aussi essayer de sortir de ce système de publisheurs périches. Et donc, il y a de plus en plus de réflexions qui sont faites sur comment on note, et notamment en France, où il y a des collèges d'universitaires qui décident de ne plus juger sur les SIGAPS et qui disent, certes, la fac décide comme ça, mais nous, on décide à, on regarde ton papier et on en parle à l'oral devant ton oral. et puis il y a aussi une autre une autre et dernière magnifique option qui est pour moi aussi très importante, ce qui s'appelle l'open science, où on va donner le plus de données qu'on fait et d'analyses qu'on fait de manière publique. Et on va impliquer les gens qui ne sont pas forcément spécialistes dans notre travail.

- Speaker #0

Très bien. Je pense qu'il va falloir qu'on fouille ce sujet sur un prochain épisode alors.

- Speaker #1

Oui, carrément, avec plaisir.

- Speaker #0

Est-ce que tu veux rajouter quelque chose sur cet épisode,

- Speaker #1

Bastien ? Il y a des très belles références, n'hésitez pas à voir ça, sur notamment Hervé Maisonneuve. C'est vraiment un blog que je vous conseille, très intéressant sur l'intégrité scientifique, si vous voulez vous régaler, qui est très très qualitatif.

- Speaker #0

Est-ce que tu veux prendre quelques secondes pour nous dire où est-ce qu'on peut te retrouver, où est-ce qu'on peut voir ton travail ?

- Speaker #1

Je suis sur Instagram, j'ai un compte qui s'appelle Critique ton article, avec des tirées du bas du 8 entre critique ton et article. Donc c'est majoritairement sur ça que j'essaie de communiquer un peu. Et là-dessus, il y a un peu de poux, il y a des vidéos sur la gériatrie, il y a des vidéos sur la méthodologie, sur la LCA, sur l'intégrité scientifique aussi. et... et puis il y a des référentiels aussi que je propose sur la LCA et sur comment faire sa thèse aussi quand on est interne, donc n'hésitez pas

- Speaker #0

Je recommande à tous nos précieux auditeurs d'aller voir ton travail qui est vraiment de très très grande qualité, merci beaucoup Bastien

- Speaker #1

Merci à toi

- Speaker #2

J'espère que cet épisode t'a plu si c'est le cas, pense à t'abonner pour ne rater aucun épisode Si tu veux me laisser une note de 5 étoiles sur ton application, ça m'aiderait aussi beaucoup. Tu peux également rejoindre la newsletter afin de recevoir une fois par mois un mail dans lequel je te transmets plein de contenus pour la médecine générale. Enfin, tu peux participer financièrement sur la cagnotte Tipeee. Toutes les ressources sont dans les notes de cet épisode. A bientôt !